[새로운 AI 칩에는 2,080억 개의 트랜지스터가 탑재] 거대 칩 기업인 NVIDIA는 AI의 규모와 속도 면에서 또 다른 도약을 제공할 Blackwell 프로세서 제품군을 출시했다.

[새로운 AI 칩에는 2,080억 개의 트랜지스터가 탑재] 거대 칩 기업인 NVIDIA는 AI의 규모와 속도 면에서 또 다른 도약을 제공할 Blackwell 프로세서 제품군을 출시했다.

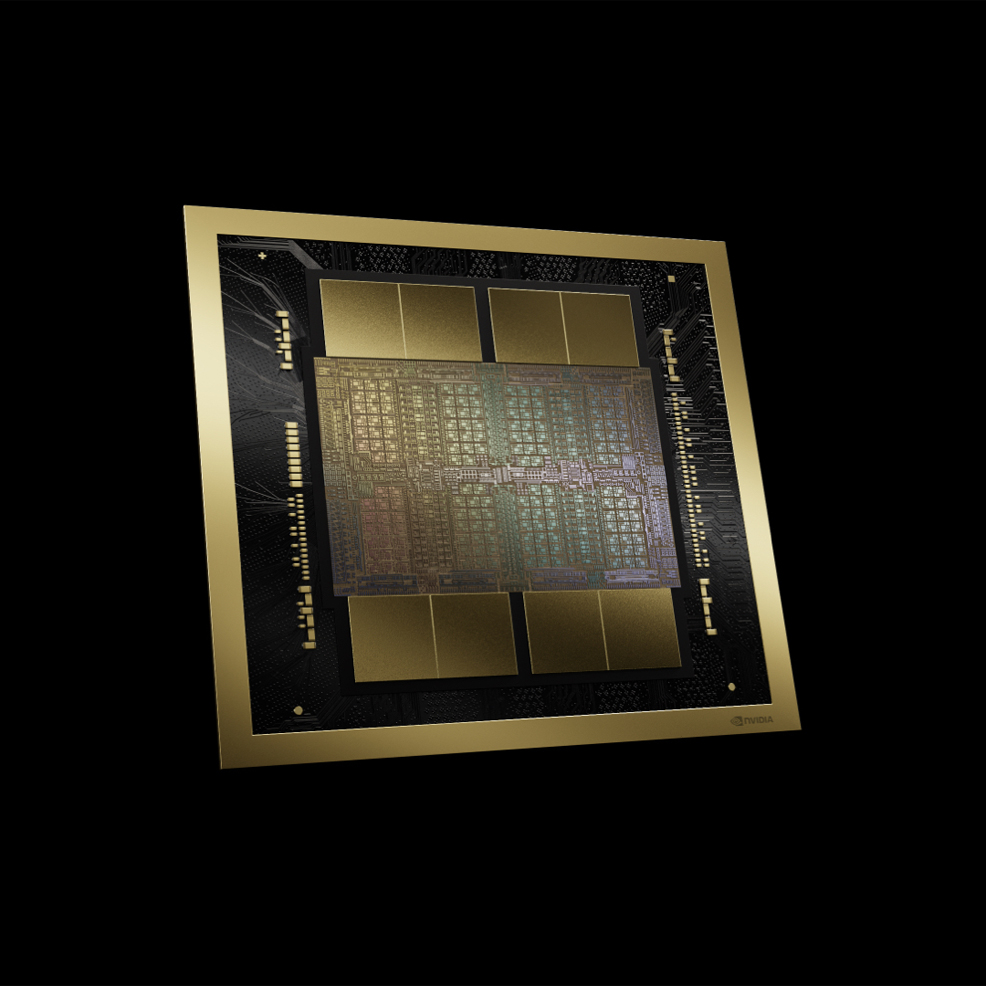

2024년 3월 22일 새로운 AI 칩에는 2,080억 개의 트랜지스터가 탑재되어 있다.

거대 칩 기업인 NVIDIA는 AI의 규모와 속도 면에서 또 다른 도약을 제공할 Blackwell 프로세서 제품군을 출시했다.

NVIDIA는 그래픽 처리 장치(GPU)가 비디오 게임과 전문적인 비주얼을 변화시킬 뿐만 아니라 인공지능(AI) 연구 및 개발의 중추가 되면서 현재 기술 붐의 선두에 서 있다.

이번 주 산호세에서 열린 GTC 컨퍼런스에서 회사는 최신 혁신기술을 공개했다. 주요 하이라이트 중 하나는 6가지 새로운 기술을 갖춘 GPU 아키텍처인 Blackwell 임이 입증되었다.

세계에서 가장 빠른 GPU인 이 차세대 칩은 컴퓨팅 및 생성 AI의 기하급수적인 성장을 유지할 것이다.

엔비디아의 창립자이자 CEO인 젠슨 황(Jensen Huang)은 “우리는 지난 30년 동안 딥 러닝 및 AI와 같은 획기적인 혁신을 가능하게 한다는 목표로 가속화된 컴퓨팅을 추구해 왔습니다.”라고 말했다.

"제너레이티브 AI는 우리 시대를 정의하는 기술입니다. Blackwell은 이 새로운 산업 혁명을 촉진하는 엔진입니다. 세계에서 가장 역동적인 기업과 협력하여 우리는 모든 산업 분야에서 AI의 약속을 실현할 것입니다."

Blackwell GPU는 각 다이에 1,040억 개의 트랜지스터로 채워져 있으며, 2,080억 개의 트랜지스터가 하나의 칩으로 통합되어 있다.

이 수치는 이전 트랜지스터 수 기록을 보유한 AMD의 최근 MI300X 가속기 보다 35% 더 많고, NVIDIA의 현재 주력 장치인 H200 보다 2.6배 더 많다.

이 제품은 TSMC(Taiwan Semiconductor Manufacturing Company)에서 개발한 맞춤형 4nm 공정을 사용하여 제조된다.

대규모 트랜지스터 수 외에도 Blackwell은 H200(141GB) 및 H100(94GB) 호퍼 아키텍처에 비해 더 많은 메모리(192GB)를 갖추고 있으며 새로운 4비트 부동 소수점(FP4) AI 추론 기능을 갖추고 있다.

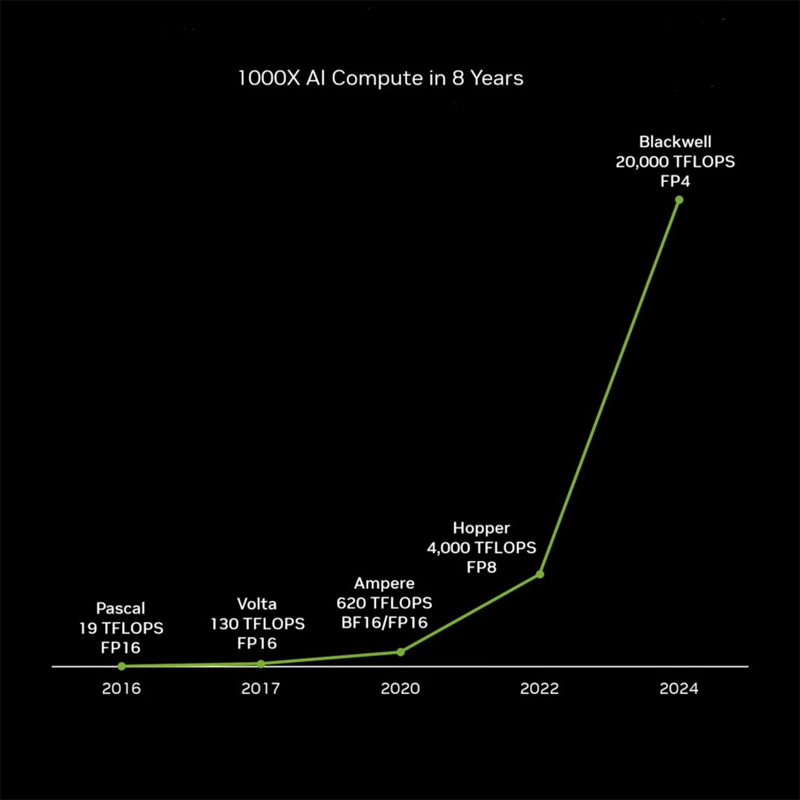

FLOPS(초당 부동 소수점 연산)로 측정하면 이는 Hopper의 5배, 2016년 Pascal의 1,000배 성능을 제공한다는 의미.

물론 이러한 프로세서를 함께 쌓아서 기능을 결합하고 더욱 향상시킬 수도 있다.

표준 버전뿐만 아니라 NVIDIA는 두 가지 더 큰 구성, 즉 Blackwell "슈퍼칩"과 랙 규모 디자인을 제공할 예정. 둘 다 아래 그림에 나와 있다.

GB200 Grace Blackwell Superchip으로 알려진 이들 중 첫 번째는 Grace CPU와 함께 두 개의 Blackwell GPU로 구성된다. 그 결과 40페타플롭스의 처리 능력(FP4)과 16TB/s의 GPU 대역폭이 생성된다.

두 번째는 36개의 Grace CPU와 함께 72개의 Blackwell GPU로 구성된 GB200 NVL72로 알려진 훨씬 더 큰 구성이다. 이 옵션은 엄청난 1,440페타플롭스와 576TB/s의 GPU 대역폭을 제공하여 현재 가장 큰 AI 시스템 보다 훨씬 더 큰 최대 10조 개의 매개변수가 있는 모델을 지원한다.

25배의 에너지 효율성

최근 몇 년 동안 에너지 효율성은 기술 부문에서 점점 더 큰 관심을 받고 있다. 수냉식 GB200 NVL72 랙은 데이터 센터의 탄소 배출량과 에너지 소비를 줄이도록 설계되었다.

액체 냉각은 컴퓨팅 밀도를 높이고 필요한 바닥 공간을 줄이며 고대역폭, 낮은 지연 시간의 GPU 통신을 가능하게 한다.

NVIDIA의 H100 공랭식 인프라에 비해 GB200 랙은 물 소비를 줄이면서 동일한 전력으로 25배 더 많은 성능을 제공할 수 있다.

Blackwell 프로세서를 채택할 것으로 예상되는 많은 조직 중에는 Amazon Web Services, Dell Technologies, Google, Meta, Microsoft, OpenAI, Oracle, Tesla 및 xAI가 있다.

NVIDIA에 따르면 첫 번째 출하량은 2024년에 예상되지만 상당한 양으로 증가하는 데는 2025년까지 걸릴 것으로 예상된다. 가격은 각각 30,000~40,000달러 사이일 것으로 예상.

마이크로소프트의 회장 겸 CEO인 사티아 나델라(Satya Nadella)는 "우리는 고객의 AI 워크로드를 강화할 수 있는 가장 진보된 인프라를 제공하기 위해 최선을 다하고 있습니다"라고 말했다.

"GB200 Grace Blackwell 프로세서를 전 세계 데이터 센터에 도입함으로써 우리는 클라우드에 NVIDIA GPU를 최적화하는 오랜 역사를 바탕으로 모든 조직에 AI에 대한 약속을 현실로 만들고 있습니다."

ChatGPT를 지원하는 회사인 OpenAI의 CEO인 Sam Altman은 "Blackwell은 엄청난 성능 향상을 제공하며 최첨단 모델을 제공하는 능력을 가속화할 것입니다."라고 말했다. "AI 컴퓨팅을 향상하기 위해 NVIDIA와 계속 협력하게 되어 기쁩니다."

구글 딥마인드(Google DeepMind)의 공동 창업자이자 CEO인 데미스 허사비스(Demis Hassabis)는 “AI의 혁신적인 잠재력은 놀랍고 세계에서 가장 중요한 일부 과학적 문제를 해결하는 데 도움이 될 것입니다.”라고 말했다.

"Blackwell의 획기적인 기술 역량은 세계에서 가장 뛰어난 사람들이 새로운 과학적 발견을 기록하는 데 필요한 중요한 컴퓨팅을 제공할 것입니다."

<저작권자 ⓒ ainet 무단전재 및 재배포 금지>

|

[세계미래보고서]시리즈, 판매제품

많이 본 기사

신기술&메타버스AR/VR 많이 본 기사

최신기사

|